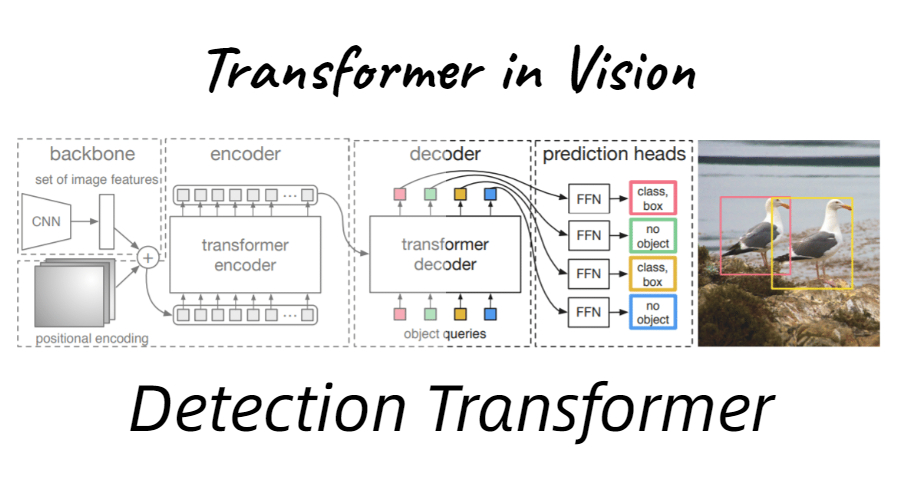

FPN(Feature Pyramid Networks for Object Detection)

FPN解决的主要问题是检测算法在处理多尺度变化问题时的不足以及对小物体检测不友好的问题。传统的方法是构造图像特征金字塔,但是计算量很大,FPN通过独特的构造避免了计算量过高的问题,并且有良好的多尺度处理性能。

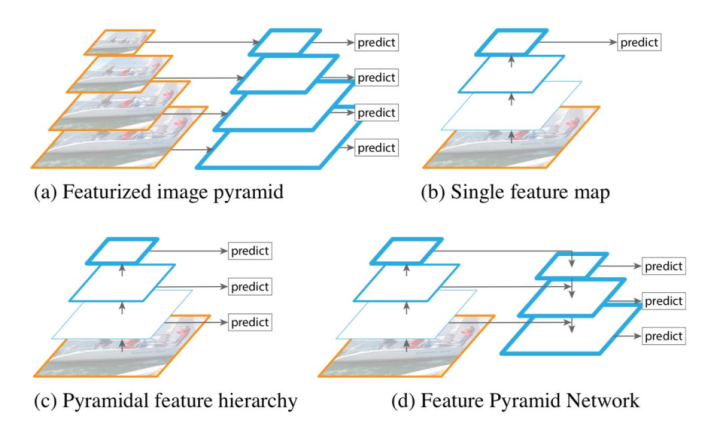

图a为传统的多尺度特征提取方法,计算量极大。

图b为单一特征的检测系统,有很大的局限性。

图c为网络多层次结构提取特征,但是存在底层语义较弱的问题。

图d为FPN金字塔特征提取,能够让各个不同尺度的特征都拥有较强的语义信息。

FPN算法

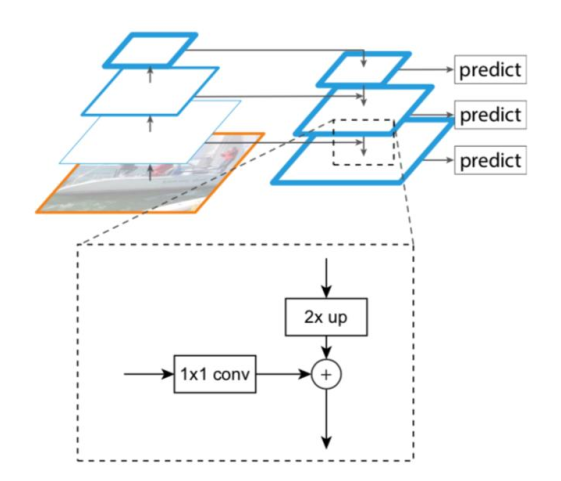

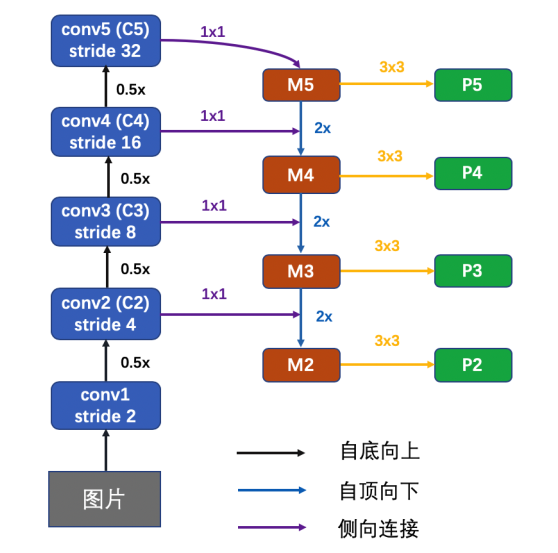

FPN包含两个部分:第一部分是自底向上的过程,第二部分是自顶向下和侧向连接的融合过程。

自底向上过程

自底向上的过程和普通的CNN没有区别。现代的CNN网络一般都是按照特征图大小划分为不同的stage,每个stage之间特征图的尺度比例相差为2。在FPN中,每个stage对应了一个特征金字塔的级别(level),并且每个stage的最后一层特征被选为对应FPN中相应级别的特征。以ResNet为例,选取conv2、conv3、conv4、conv5层的最后一个残差block层特征作为FPN的特征,记为{C2、C3、C4、C5}。这几个特征层相对于原图的步长分别为4、8、16、32。

自顶向下过程

自顶向下的过程通过上采样(up-sampling)的方式将顶层的小特征图(例如20)放大到上一个stage的特征图一样的大小(例如40)。这样的好处是既利用了顶层较强的语义特征(利于分类),又利用了底层的高分辨率信息(利于定位)。上采样的方法可以用最近邻差值实现。为了将高层语义特征和底层的精确定位能力结合,作者提出类似于残差网络的侧向连接结构。侧向连接将上一层经过上采样后和当前层分辨率一致的特征,通过相加的方法进行融合。(这里为了修正通道数量,将当前层先经过1x1卷积操作。)如图所示。

具体的,C5层先经过1x1卷积,得到M5特征。M5通过上采样,再加上C4经过1x1卷积后的特征,得到M4。这个过程再做两次,分别得到M3和M2。M层特征再经过3x3卷积,得到最终的P2、P3、P4、P5层特征。另外,和传统的图像金字塔方式一样,所有M层的通道数都设计成一样的,本文都用d=256。细节图如下所示(以ResNet为例):

FPN本身不是检测算法,只是一个特征提取器。它需要和其他检测算法结合才能使用。 RetinaNet就是一个运用了FPN的网络。

代码实现

以Resnet为Backbone

1 | class PyramidFeatures(nn.Module): |